نگرانی جدید در مورد کلاهبرداری از طریق تقلید صدا با هوش مصنوعی

مخاطب24:زنی پس از شنیدن صدای گریه دخترش در تماس تلفنی دچار نگرانی شد؛ تماسی که در آن یک مرد مدعی ربودن دختر او شده و از این زن تقاضای باج کرده است.

لحن صدای دختر در این تماس صدای واقعی او نبود، بلکه توسط فناوری هوش مصنوعی در تلاش برای انجام یک کلاهبرداری ایجاد شده بود؛ موضوعی که نگرانیها در مورد سوءاستفاده از هوش مصنوعی را افزایش داده است.

کارشناسان تأکید کردهاند که برجستهترین خطر هوش مصنوعی توانایی این فناوری در از بین بردن مرز بین واقعیت و تخیل و ارائه ابزارهای موثر و ارزان به مجرمان است.

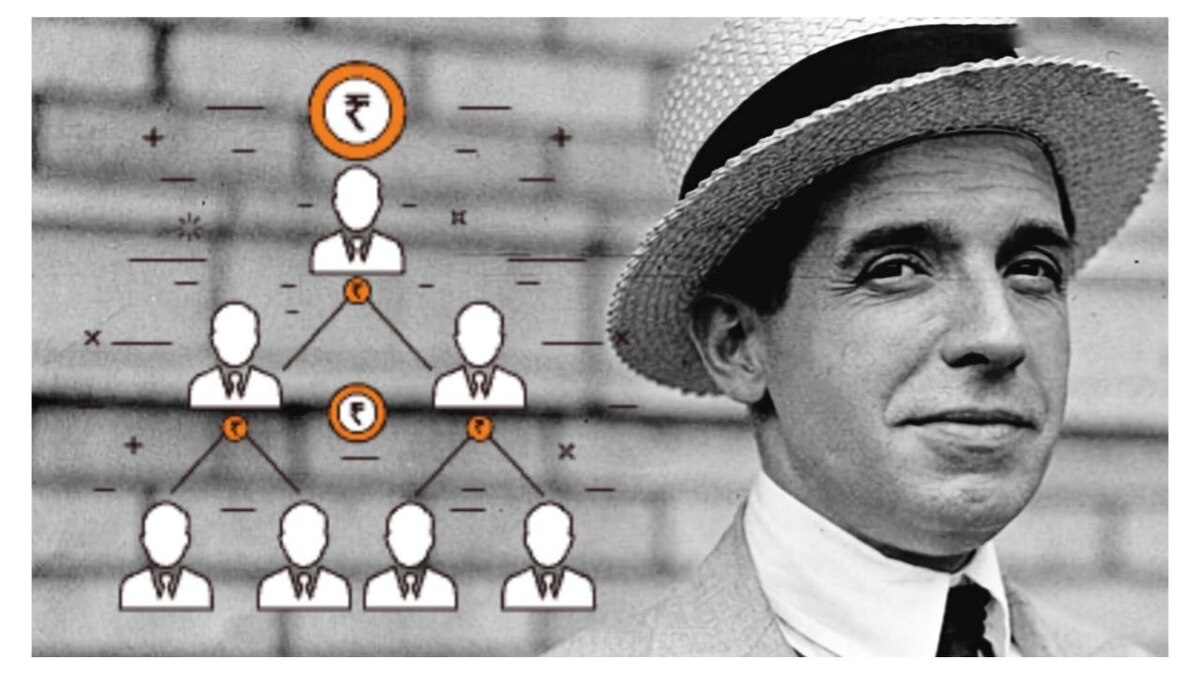

کلاهبرداریهای تلفنی اخیر با استفاده از ابزارهای تقلید صدا مبتنی بر هوش مصنوعی که به راحتی و به صورت آنلاین در دسترس هستند، مقامات را نگران کردهاند.

جنیفر دی استفانو، مادری که در آریزونا زندگی میکند، از طریق تلفن صدایی را میشنود که میگوید: "مامان، کمکم کن، لطفا کمک کن. " این مادر فکر کرده بود که صدا متعلق به دختر ۱۵ ساله اش است که برای تمرین اسکی به بیرون رفته است؛ و در مصاحبهای با یک شبکه تلویزیونی محلی، در ماه آوریل گفت: "صدا مانند صدای دخترم بود، با همان گریههای دخترم. من یک لحظه شک نکردم که ممکن است او نباشد. " کلاهبردار که از شماره ناشناس با مادر تماس گرفته بود در ازای آزادی دختر یک میلیون دلار درخواست کرده بود.

اکنون این حادثه که پس از تماس دی استفانو با دخترش به سرعت به پایان رسید، در دست بررسی مقامات ذیربط است و در افشای کلاهبرداریهای احتمالی ناشی از استفاده مجرمان سایبری از برنامههای هوش مصنوعی نقش داشته است.

وسیم خالد، مدیر عامل شرکت Blackbird.ai، تأکید کرد که رونویسی صدای هوش مصنوعی، که تشخیص آن از صدای انسان تقریباً غیرممکن شده است، به افراد بد نیت مانند کلاهبرداران اجازه میدهد تا اطلاعات و مبالغی را از قربانیان به روشی مؤثرتر به دست آورند.

بسیاری از برنامه ها، رایگان و به طور گسترده و آنلاین در دسترس هستند که امکان کپی صدای واقعی یک فرد را از طریق یک برنامه هوش مصنوعی بر اساس ضبط کوتاه صدای آن شخص فراهم میکنند. کلاهبردار میتواند ضبطهای مشابهی از محتویات ارسال شده توسط قربانی را به صورت آنلاین بدست آورد.

یک نظرسنجی از حدود ۷۰۰۰ نفر در ۹ کشور، از جمله ایالات متحده، نشان داد که از هر چهار نفر یک نفر هدف تلاش برای کلاهبرداری توسط هوش مصنوعی قرار گرفته است یا فردی را میشناسد که تحت تاثیر فرآیند مشابهی بوده است.

بر اساس این نظرسنجی که ماه گذشته توسط شرکت Mac Avi Labs منتشر شد، ۷۰ درصد از افراد مورد بررسی اظهار داشتند که از توانایی خود در تشخیص صدای واقعی و صدای بازتولید شده مطمئن نیستند.

چندی پیش و پس از آنکه تعدادی از کاربران اینترنت کلیپی جعلی از "اما واتسون" بازیگر زن، در حال خواندن گزیدههایی از کتاب Mein Kampf آدولف هیتلر را منتشر کردند، استارتاپ Eleven Labs مجبور شد اعتراف کند که ابزار رونویسی صدای هوش مصنوعی آن میتواند برای اهداف مخرب نیز استفاده شود.

براین اساس، ما به سرعت به نقطهای نزدیک میشویم که دیگر نمیتوانیم به محتوای پست آنلاین اعتماد کنیم و برای این منظور باید از فناوریهای جدید استفاده کنیم تا مطمئن شویم شخصی که فکر میکنیم در حال صحبت با او هستیم واقعاً همان کسی است که میخواهیم با او ارتباط برقرار کنیم.